s5unnyjjj's LOG

ML - Theory #5 : 엔트로피 (Entropy), 크로스엔트로피 (Cross Entropy), 상대 엔트로피(Relative Entropy) 본문

ML - Theory #5 : 엔트로피 (Entropy), 크로스엔트로피 (Cross Entropy), 상대 엔트로피(Relative Entropy)

s5unnyjjj 2021. 4. 21. 21:43엔트로피 (Entropy)

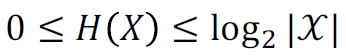

불순도를 수치화한 지표, 불확실성 측정의 정도를 의미한다. 엔트로피 수치가 0이라면, 해당 분류에 속하는 개체의 속성이 모두 동일하다. 즉, 분류를 하지 않아도 된다. 엔트로피 수치가 0에 가까워질수록 불순도가 낮고, 엔트로피 수치가 1에 가까워질수록 불순도가 높다. 즉, 불순한 상태는 분류하기 어려운 상태로 볼 수 있으며, 불순한 상태일수록 엔트로피 수치는 커지며 불순도가 높을수록 분류하기 어렵다. 결론은 불순도와 엔트로피는 비례관계이다. 식은 아래와 같다.

크로스 엔트로피 (Cross Entropy)

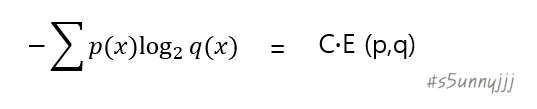

Estimated value와 실제 정답이 되는 값이 서로 얼마나 근사한지 보는 것으로 주로 classification에 사용된다. 식은 아래와 같다.

상대 엔트로피 (Relative Entropy)

두 확률분포의 다름 정도. 종종 두 분포 사이의 거리를 계산할 때 흔히 사용된다. 또한 쿨백 라이블러 발산(Kullback-Leibler divergence, KL) 이라고도 불린다. 상대 엔트로피는 항상 0 이상의 값을 가지며 비대칭적(Asymmetric)이다. 또한 두 확률분포가 동일 할 때(= p와 q가 같은 경우에는), KL-Divergence는 0이다. 식은 아래와 같다.

- p와 q의 일반적인 의미

- p : 참 분포(True distribution), 실제 관찰 데이터(Observations)

- q : 가설(Theory), 모델(Model), P의 근사(Approximation)

∵ Entropy는 1개의 probability function을 사용하고, Relative entropy는 2개의 probability function을 사용한다.

>> 위 내용은 필자가 공부하여 직접 정리한 내용이며, 위 그림 역시 직접 그린 그림이므로 워터마크 "s5unnyjjj"를 삽입하였음을 알려드립니다.

>> 부족한 점이 많을 수 있기에 잘못된 내용이나 궁금한 사항이 있으면 댓글 달아주시기 바랍니다.

>> 긴 글 읽어주셔서 감사합니다.